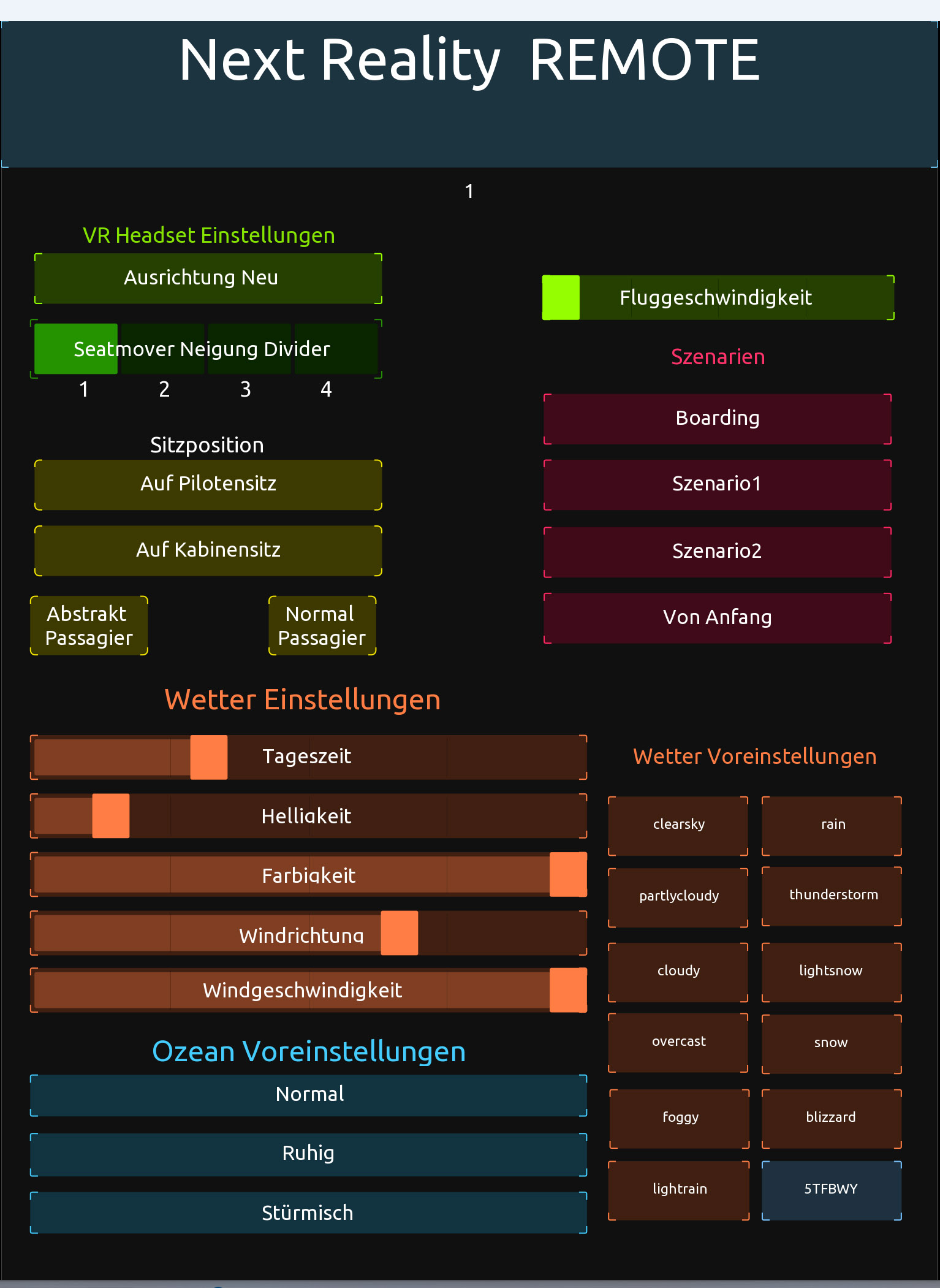

Bereits zu Beginn des Projektes waren sich die Partner einig darüber, dass eine Art Fernbedienung für verschiedene Wettersituationen und Einstellungen an den Szenarien benötigt wird. Zum Einen sollte es möglich sein, durch die Einstellungen die Dramatik im Szenario und damit die Immersion zu erhöhen. Zum Anderen wird die Fernbedienung die Möglichkeit bieten, den Trainingsteilnehmer bei zu hohem Stresslevel wieder aus der dramatischen Situation eines Heliktopterabsturzes in ein beruhigendes Szenario zurückzubringen. Für die aktuellen Szenarien wurde die Applikation TouchOSC implementiert, welche auf einem iPad installiert wurde. Auf Unreal Seite werden Parameter für die Einstellungen am Wetter und den Szenarien bereitgestellt. Für die Verbindung zwischen Unreal Engine und TouchOSC wird über die UDP Protokoll kommuniziert und die Eingabebefehle in MIDI Signale übersetzt. TouchOSC erwies sich als sehr flexibel und nutzerfreundlich. Die Erstellung der Benutzeroberfläche erfolgt in einem leicht zu bedienenden Editor. Nach erfolgreicher Konfiguration der Slider und Buttons für die einzustellenden Parameter wird über den Play Button die Remote aktiviert. Wird die NextReality Anwendung dann gestartet, können alle Werte bequem über das Tablet gesteuert werden.

Folgende Parameter wurde bis jetzt eingebaut:

- Ausrichtung des VR Headsets zurücksetzen

- Seatmover Neigung

- Sitzposition

- Szenarienauswahl (Boarding, Normalflug, Absturz)

- Wetter (Tageszeit, Helligkeit, Wind)

- Ozean Presets

- Wetter Presets

Aufgrund der Tatsache, dass TouchOSC kein OpenSource ist und Lizenzen für den kommerziellen Einsatz erworben werden müssten, haben sich die Projektpartner dazu entschieden, die Remote Steuerung neu zu programmieren und in die App für die Vitaldatenmessung, die durch das Fraunhofer IGD entwickelt wird, zu integrieren.